Para que tu sitio web destaque en internet, es fundamental entender cómo Google encuentra y organiza tu contenido. En este artículo, te explicamos de forma clara cómo funcionan el rastreo y la indexación, dos procesos clave para que tus páginas aparezcan en los resultados de búsqueda.

Qué es el rastreo e indexación

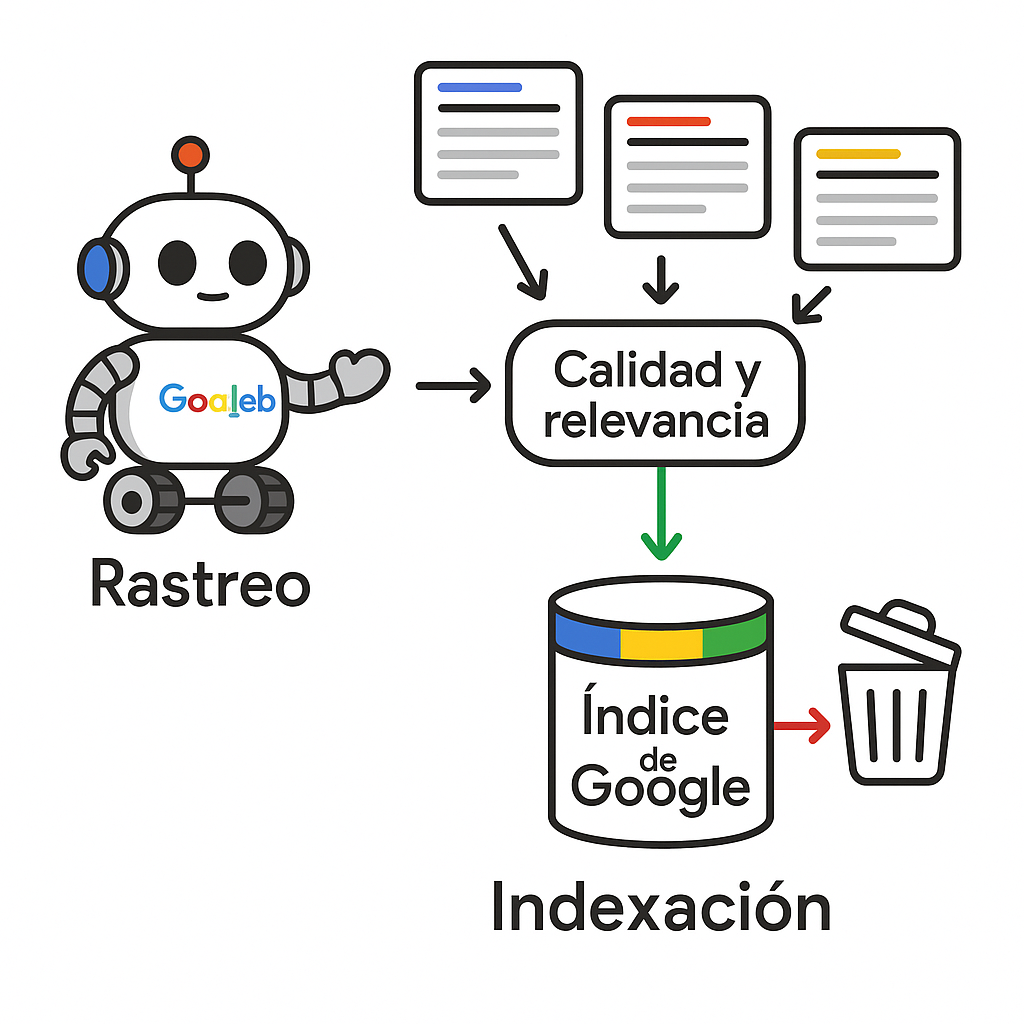

Los motores de búsqueda como Google realizan dos acciones fundamentales para mostrar contenido a los usuarios. Primero, mediante el rastreo, sus robots (llamados bots o crawlers) exploran internet siguiendo enlaces y mapas de sitio. Luego, en la fase de indexación, deciden qué páginas de tu sitio web merecen guardarse en su enorme base de datos (índice) para mostrarlas cuando alguien busque información relacionada.

Diferencia entre rastreo e indexación

Aunque ambos procesos están conectados, tienen propósitos distintos. El rastreo es cuando los bots descubren y leen tu contenido, mientras que la indexación es cuando Google decide si ese contenido es lo suficientemente bueno para incluirlo en su índice. Por ejemplo, Googlebot puede encontrar una nueva página de tu blog al seguir un enlace, pero solo la indexará si considera que tiene información valiosa y original, y que no está bloqueada con etiquetas noindex.

Esta diferencia es crucial para tu SEO. Una página puede ser rastreada muchas veces pero nunca indexada si Google piensa que no es útil para los usuarios. Por otro lado, algunas páginas pueden permanecer en el índice incluso después de dejar de ser rastreadas, especialmente si otras páginas importantes enlazan a ellas.

Cómo decide Google indexar

En el proceso de indexación web, Google analiza varios aspectos importantes:

- La originalidad y calidad del contenido

- Si es relevante para lo que buscan los usuarios

- La estructura técnica de la página

- La autoridad general de tu sitio

Las páginas con contenido detallado, único y bien organizado tienen más posibilidades de ser indexadas.

Google también evalúa factores técnicos como:

- Velocidad de carga

- Adaptación a móviles

- Posibles errores de rastreo

Si tu sitio tiene problemas constantes (como errores de servidor o páginas muy lentas), Google puede rastrearlo con menos frecuencia y ser más estricto al indexar. Las etiquetas como meta robots y canonical también influyen en estas decisiones.

Presupuesto de rastreo y calidad

El presupuesto de rastreo es el tiempo y recursos que Google dedica a explorar tu sitio. No es infinito: depende del tamaño de tu web, su popularidad, con qué frecuencia se actualiza y cómo funciona tu servidor. Sitios pequeños generalmente no tienen problemas con esto, pero sitios con miles de páginas necesitan optimizar este proceso.

La clave está en la calidad del contenido y cómo está organizado tu sitio. Muchas páginas con poco valor (como contenido duplicado o filtros repetitivos) hacen que Google pierda tiempo en ellas en lugar de enfocarse en tus páginas importantes. Eliminar este tipo de páginas y mejorar la estructura de tu sitio ayuda a que Google use mejor su presupuesto de rastreo.

Cómo verificar la indexación en Google

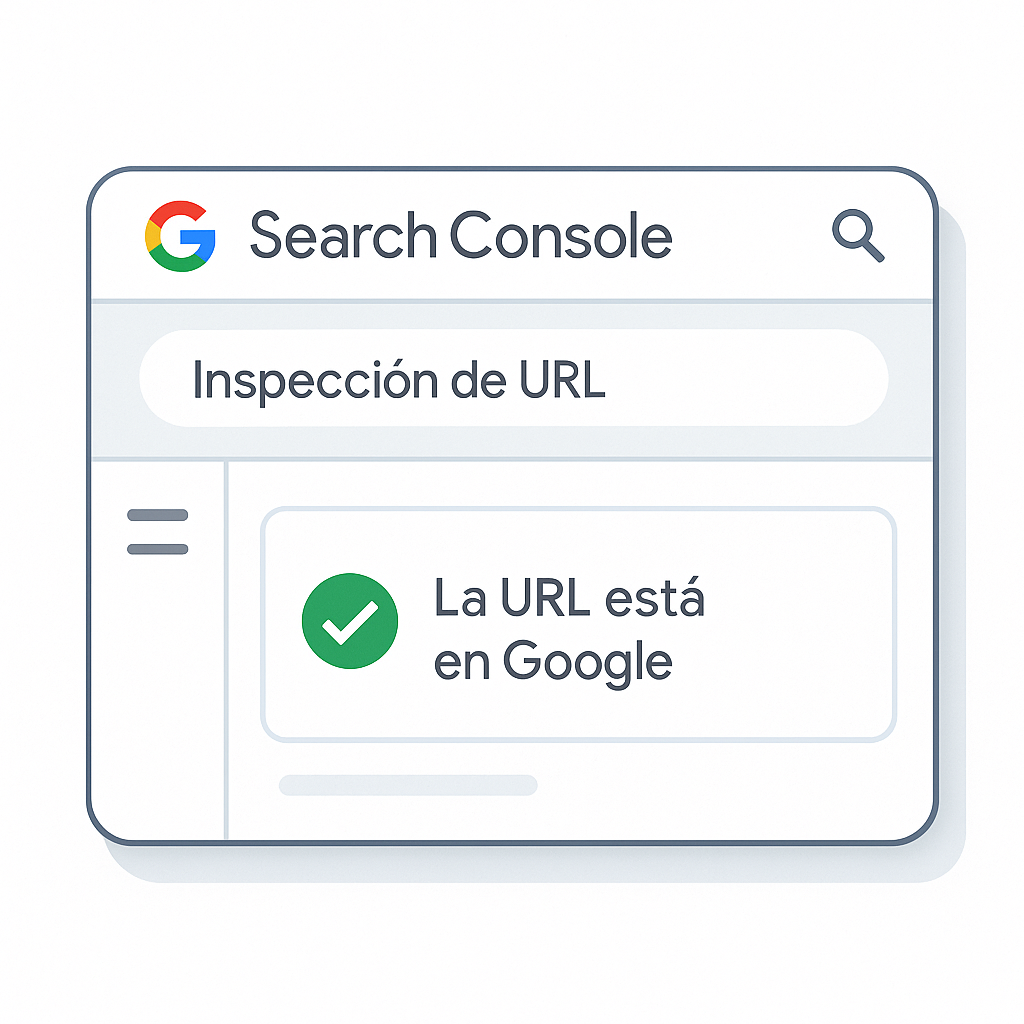

Conocer el estado de indexación de tu web es crucial para solucionar problemas y mejorar tu posicionamiento. Google ofrece herramientas prácticas para comprobar qué páginas han sido rastreadas e indexadas , detectando posibles obstáculos que afecten tu visibilidad.

Search Console y operador site

Google Search Console es tu mejor aliado para monitorear la indexación de tu sitio . La función "Inspección de URL" muestra el estado exacto de cada página, incluyendo su presencia en el índice de Google y posibles problemas técnicos. Esta información es más precisa que otros métodos.

- Operador site: Usa "site:tudominio.com" en la búsqueda para ver un estimado de páginas indexadas

- Informe de cobertura: Muestra páginas válidas, excluidas y con errores en la indexación

- Inspección de URL: Proporciona detalles específicos sobre el rastreo e indexación

- Sitemaps: Permite enviar y monitorear tu mapa del sitio en XML

El operador site: sigue siendo útil para detectar problemas básicos, pero para decisiones técnicas sobre rastreo e indexación , los datos de Search Console son más confiables.

Solicitar rastreo y seguimiento

Cuando hagas cambios importantes en tu web , solicita nuevo rastreo mediante la opción "Solicitar indexación" en Google Search Console . Esto es especialmente útil tras corregir errores o añadir nuevo contenido relevante.

El monitoreo constante es clave. Revisa semanalmente los informes para detectar problemas como "Rastreada pero no indexada". Mejora el contenido , optimiza la velocidad o ajusta la estructura de enlaces internos cuando encuentres estos mensajes.

Cómo funciona el SEO técnico para indexación

El SEO técnico establece los fundamentos que ayudan a los motores de búsqueda a analizar, entender e incluir tu contenido en sus bases de datos. Elementos clave como los sitemaps , el uso adecuado de etiquetas canonical y la optimización del renderizado de JavaScript son vitales para mejorar la visibilidad de tu web en los resultados naturales.

Sitemaps, canonical y hreflang

Estos elementos trabajan conjuntamente para agilizar la indexación de páginas en sus versiones definitivas, evitando problemas de contenido duplicado. Un sitemap XML bien estructurado acelera la detección de URLs nuevas o actualizadas, mientras que las etiquetas canonical contribuyen a fortalecer la relevancia de la versión principal de cada página. Esta coordinación es especialmente útil para sitios con múltiples variantes de productos o contenidos similares.

- Sitemap XML: Debe contener únicamente URLs canónicas con código 200, omitiendo redirecciones o páginas bloqueadas

- Etiquetas canonical: Señalan la versión preferida cuando existen varias URLs con contenido parecido o parámetros de filtrado

- Hreflang: Esencial para sitios en varios idiomas, evita duplicados entre versiones regionales y optimiza la indexación geográfica

- Meta robots: Controlan directamente las instrucciones de indexar y el seguimiento de enlaces en cada página

La aplicación correcta de estos componentes necesita coherencia en toda la estructura del sitio. Por ejemplo, en una tienda online con filtros, páginas con parámetros como "?color=rojo&talla=M" deberían apuntar mediante canonical a la página principal de categoría, evitando que Google indexe cientos de combinaciones sin valor único.

JavaScript y renderizado

El manejo del JavaScript es fundamental para entender cómo funciona la indexación de Google en sitios modernos. Muchas webs actuales cargan contenido dinámicamente usando JavaScript, lo que puede crear problemas si los elementos principales no están disponibles durante el rastreo inicial. Aunque Google realiza un renderizado secundario, este puede retrasarse o fallar en algunos casos.

Para sitios con mucho contenido generado por JavaScript, recomendamos implementar Server-Side Rendering (SSR) o prerenderizado para garantizar que la información importante esté accesible desde el principio. Por ejemplo: si tu tienda online muestra descripciones de productos mediante AJAX, considera generar esta información directamente en el servidor para asegurar que Google pueda indexar correctamente los detalles de cada producto.

Facetas, errores y limpieza

Los sistemas de facetas en e-commerces pueden crear miles de combinaciones de URLs que desperdician el presupuesto de rastreo . Páginas como "/zapatos?color=negro&marca=nike&precio=50-100" generan variaciones infinitas sin contenido único. La mejor solución es aplicar canonical hacia la página principal de categoría o usar noindex para combinaciones muy específicas.

Los fallos técnicos como respuestas 4xx y 5xx afectan negativamente tanto al rastreo como a la indexación . Un error 404 es normal para páginas eliminadas, pero errores 500 frecuentes indican problemas de servidor que pueden hacer que Google reduzca sus visitas. Monitorear estos errores en Search Console y resolverlos rápidamente mantiene la salud técnica del sitio.

Una limpieza regular del índice , eliminando páginas de bajo valor, mejora la eficiencia del rastreo . Esto incluye páginas de búsqueda interna vacías, archivos temporales accesibles o páginas de prueba indexadas por error. Usar herramientas como Screaming Frog para revisiones técnicas periódicas ayuda a identificar y solucionar estos problemas antes de que impacten el rendimiento general.

Control del rastreo con robots y sitemaps

Administrar adecuadamente el archivo robots.txt junto con los sitemaps XML es esencial para gestionar cómo los motores de búsqueda exploran y procesan tu contenido . Estas herramientas trabajan en conjunto, dirigiendo eficientemente el rastreo hacia las páginas más importantes mientras protegen áreas administrativas o sin relevancia para el SEO .

Robots.txt correcto y seguro

El archivo robots.txt, ubicado en la raíz de tu dominio (/robots.txt), actúa como primera barrera para la indexación web . Una configuración incorrecta podría bloquear el acceso a secciones importantes o, incluso, revelar áreas que deben mantenerse privadas. Un error común es usar "Disallow: /", lo que impediría completamente que los bots de los motores de búsqueda accedan al sitio.

Para una implementación óptima, solo deberías restringir zonas como /wp-admin/, /panel/ o /admin/, garantizando que el contenido público permanezca accesible. En sitios WordPress, es crucial incluir "Allow: /wp-admin/admin-ajax.php", ya que este recurso permite a Google interpretar correctamente ciertas funcionalidades.

Aquí tienes un ejemplo de configuración adecuada:

| Directiva | Valor | Propósito |

| User-agent | * | Aplica a todos los robots |

| Disallow | /admin/ | Bloquea panel administrativo |

| Disallow | /tmp/ | Bloquea archivos temporales |

| Allow | /blog/ | Permite acceso al blog |

| Sitemap | https://tudominio.com/sitemap.xml | Indica ubicación del mapa |

Sitemaps canónicos y limpios

Para optimizar la indexación con Google , tu sitemap debe incluir únicamente URLs canónicas con estado 200, evitando redirecciones, páginas bloqueadas por robots.txt o URLs con parámetros innecesarios. El objetivo es proporcionar a los motores de búsqueda un mapa exacto de tu contenido valioso, acelerando el descubrimiento de páginas nuevas o actualizadas.

Organiza el sitemap siguiendo la estructura de tu web , priorizando las páginas principales. En sitios grandes, divide el sitemap en varios archivos temáticos (productos, blog, páginas fijas) y crea un índice que los agrupe. Este método facilita la gestión y permite un control más preciso sobre las secciones con cambios frecuentes.

Enlazado interno eficiente

La red de enlaces internos determina cómo se distribuye la autoridad en tu sitio y qué páginas tienen más posibilidades de ser rastreadas regularmente. Las páginas clave deben estar accesibles en máximo tres clics desde la portada y recibir enlaces desde varias secciones relevantes.

Una estrategia efectiva incluye enlaces contextuales desde artículos del blog hacia páginas comerciales relacionadas, breadcrumbs que ayuden a usuarios y bots , y menús de navegación que conecten las áreas principales. Los textos de anclaje deben ser descriptivos para mejorar el contexto semántico.

En sitios con mucho contenido, implementar sistemas de artículos relacionados y enlaces hacia contenido fundamental ayuda a redistribuir autoridad desde páginas populares hacia material más específico. La experiencia demuestra que mejorar el rastreo mediante una estructura de enlaces eficiente puede incrementar significativamente la indexación de páginas relevantes que antes no se indexaban.

De indexación a SEO y ranking

Una vez que los motores de búsqueda como Google han terminado de rastrear e indexar tu sitio, empieza la etapa más importante: determinar qué posición ocuparán tus páginas en los resultados. Tener tu contenido en el índice es solo el primer paso - el verdadero desafío es optimizar todos los factores que afectan al SEO para conseguir una mejor visibilidad.

Factores que influyen en la búsqueda

El rastreo e indexación son la base, pero el posicionamiento depende de más de 200 factores que Google evalúa continuamente. Aunque la calidad del contenido sigue siendo fundamental, aspectos técnicos como la velocidad de carga, la adaptabilidad a móviles y la estructura del sitio influyen directamente en cómo aparecen tus páginas indexadas .

Los algoritmos de los motores de búsqueda analizan lo que realmente busca el usuario. Por ejemplo:

- Búsqueda informativa: "Cómo hacer pan casero" muestra guías paso a paso

- Búsqueda comercial: "Comprar harina para panadería" muestra tiendas online

Otros elementos clave incluyen:

- Experiencia del usuario: Tiempos de carga rápidos y diseño responsive

- Autoridad del sitio: Enlaces entrantes de calidad y menciones relevantes

- Contexto personal: Ubicación, dispositivo e historial de búsqueda

Acciones prácticas prioritarias

Para transformar una buena indexación en visitas reales, combina mejoras técnicas con contenido de valor. Empieza resolviendo problemas que afecten a tus páginas indexadas , como:

- Velocidad de carga lenta

- Errores 404 o enlaces rotos

- Contenido duplicado

El monitoreo continuo es esencial. Usa herramientas como Google Search Console para:

- Identificar páginas con buen posicionamiento pero bajo tráfico

- Detectar errores en el proceso de rastreo

- Optimizar el contenido existente

En nuestra experiencia, revisiones técnicas periódicas (cada 3-6 meses) ayudan a mantener un buen rendimiento en los motores de búsqueda .