Le JavaScript est désormais un pilier indispensable du développement web moderne, mais son implémentation peut sérieusement compromettre le référencement naturel (SEO). Ce paradoxe tient au fait qu'une page parfaitement fonctionnelle pour les utilisateurs peut rester totalement invisible aux yeux de Google et des autres moteurs de recherche.

Ce guide complet, fruit de plusieurs années d'expertise en optimisation de sites complexes, vous dévoile toutes les clés pour réussir votre SEO JavaScript . Nous ne nous contentons pas des théories : nous partageons des stratégies éprouvées, des checklists pratiques et des conseils d'experts permettant d'assurer à votre contenu une excellente visibilité et des performances optimales dans les résultats de recherche.

Points clés à retenir

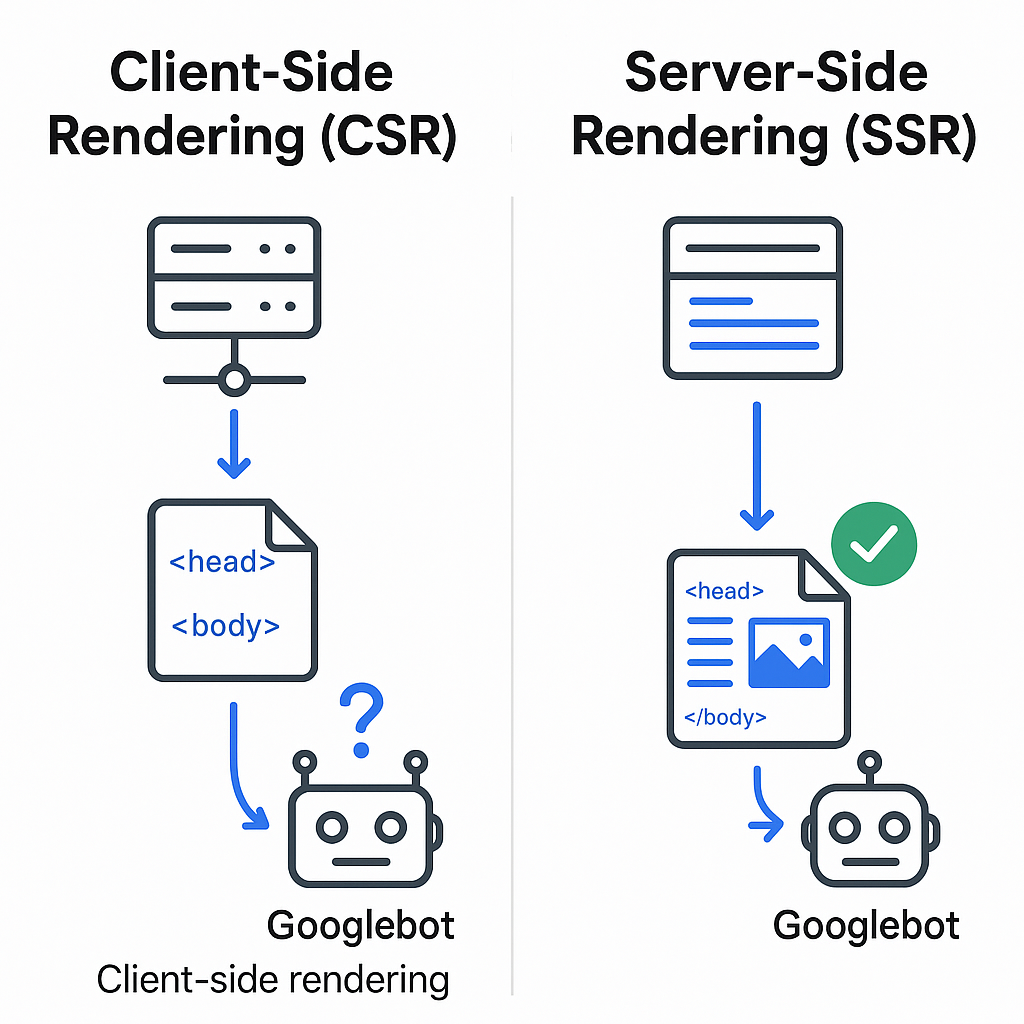

- Le rendu est primordial : Google doit impérativement "voir" votre contenu. Le server-side rendering (SSR) reste la solution la plus fiable pour les pages stratégiques en matière de référencement.

- Performances déterminantes : Les Core Web Vitals (LCP, INP, CLS) sont directement impactés par le JavaScript. L'optimisation de vos scripts influence directement votre positionnement.

- Les bases du SEO restent essentielles : Des URL lisibles, des liens valides et des métadonnées incluses dans le code source original constituent des prérequis incontournables.

- Contrôles réguliers : Utilisez la Google Search Console et des outils SEO comme Screaming Frog pour simuler le rendu d'une page et détecter les problèmes invisibles.

Comment Google traite le JavaScript

Pour optimiser un site internet utilisant JavaScript, il faut absolument comprendre comment les moteurs de recherche interprètent ce langage. À la différence du HTML classique, qui est instantanément lisible, le contenu dynamique généré par JavaScript nécessite un processus complexe d' exploration et de rendu , ce qui peut ralentir ou même empêcher l'indexation.

Le processus d'exploration du JavaScript par Google

Google analyse vos pages JavaScript en trois étapes clés :

- Exploration initiale : Le robot Googlebot commence par télécharger le code HTML brut de votre page, tel qu'affiché dans l'option "Afficher le code source" (Ctrl+U).

- File d'attente pour le rendu : Pour le contenu dynamique (typique des applications CSR ), Google place la page en attente. Le Web Rendering Service (WRS), utilisant Chrome, exécute ensuite le JavaScript pour reconstruire la page complète.

- Indexation finale : Une fois le rendu terminé, Google peut analyser le contenu définitif et l'intégrer à ses résultats.

Le défi majeur ? L'étape de rendering est très gourmande en ressources et peut prendre plusieurs heures, voire des jours. Pendant ce laps de temps, vos concurrents utilisant du HTML statique sont déjà indexés et bénéficient potentiellement d'un meilleur classement.

💡 Conseil d'expert : Pour vérifier exactement ce que Google perçoit après le rendu , utilisez l' Outil d'inspection d'URL dans Google Search Console. Lancez un "Test d'URL en direct" et examinez attentivement la capture d'écran ainsi que le HTML généré. L'absence de contenu principal signale un problème critique d'indexation à résoudre en urgence.

Pourquoi le rendu côté serveur transforme votre SEO

Le server-side rendering (SSR) révolutionne l'indexation en fournissant aux robots comme Googlebot une page HTML entièrement construite avant même son arrivée dans le navigateur. Cette approche permet d'afficher immédiatement tous les éléments clés pour le référencement : titres, liens et métadonnées, sans dépendre de l'exécution du JavaScript côté client.

- Client-Side Rendering (CSR) : Dans ce cas, le serveur envoie une structure minimale (

<div id="app"></div>) et c'est au navigateur qu'incombe la lourde tâche d'exécuter le JavaScript pour afficher le contenu. Cette méthode présente des faiblesses évidentes pour l'exploration par les robots. - Server-Side Rendering : Ici, le rendu s'effectue côté serveur avant l'envoi au client. Cette solution optimise à la fois l'indexation et les performances globales du site.

L'amélioration des Core Web Vitals est particulièrement notable. Le SSR booste le Largest Contentful Paint (LCP) en fournissant immédiatement le contenu principal, évitant ainsi le délai causé par le chargement des scripts JavaScript.

Erreurs techniques qui compromettent l'indexation JavaScript

Certains problèmes techniques, parfois invisibles pour les utilisateurs, peuvent rendre votre site inexploitable pour les robots. Un consultant SEO expérimenté identifie rapidement ces obstacles majeurs.

- 🚫 Bloquer les ressources .js et .css dans robots.txt

- Conséquence : Google ne peut pas restituer correctement vos pages, ne voyant qu'une version tronquée sans styles ni fonctionnalités. Par exemple, un blocage comme

Disallow: /assets/devient catastrophique si ce dossier contient vos fichiers CSS et JavaScript essentiels. - 🔗 Navigation basée sur des fragments (#)

- Conséquence : Google ignore généralement ce qui suit le

#dans une URL. Pour des sections comme/services#seo, préférez des structures claires (/services/seo) en utilisant l'API History pour une navigation optimisée pour le SEO. - 🖱️ Contenu affiché uniquement après interaction utilisateur

- Conséquence : Googlebot étant incapable d'interagir avec l'interface, tout contenu crucial doit être visible dès le chargement initial de la page pour être pris en compte dans l'indexation.

- 🎭 Modification des balises SEO critiques côté client

- Conséquence : Les modifications dynamiques des balises

canonicaloutitlevia JavaScript créent des incohérences : Google pourrait indexer la version initiale avant l'exécution des scripts. - ⛓️ Redirections gérées uniquement côté client

- Conséquence : Ces redirections JavaScript gaspillent le budget de crawl. Google doit attendre le rendu complet pour voir la destination finale, ralentissant considérablement l'exploration de votre site.

Ce guide d'introduction vous présente les fondamentaux du référencement naturel et propose une méthode pratique, en mettant l'accent sur le SEO JavaScript : comment les robots analysent et indexent le contenu rendu en JavaScript, comment configurer vos fichiers sitemap et robots.txt, les distinctions entre le rendu côté client et côté serveur , l'emploi des données structurées et l' optimisation des performances pour garantir que vos pages JavaScript soient correctement référencées. Vous y découvrirez également des astuces pour la recherche de mots-clés, la structure HTML, les liens internes, les backlinks ainsi que les outils indispensables ( Google Search Console, PageSpeed Insights, GA4) pour évaluer vos résultats. Consultez le guide complet sur le SEO et JavaScript .

Optimisation JavaScript pour les Core Web Vitals

Un JavaScript trop lourd et mal optimisé représente le principal risque pour vos Core Web Vitals, ces métriques qui impactent directement votre classement dans Google . Une optimisation technique rigoureuse est essentielle pour un bon référencement .

Améliorer rapidement LCP et INP

- Découpage intelligent du code : Ne forcez pas vos visiteurs à télécharger tout le JavaScript de votre application en une seule fois. Préférez diviser votre code en modules légers, chargés uniquement quand nécessaire.

- Bonnes pratiques : Utilisez les imports dynamiques

import()pour ne charger les composants que sur les pages concernées.

Exemple concret : Le code splitting, c'est comme une bibliothèque qui vous donne les livres au compte-gouttes plutôt que de vous submerger dès l'entrée.

- Chargement optimisé (async/defer) : Pour les scripts non critiques, utilisez systématiquement ces attributs :

<script src="analytics.js" async></script>: Téléchargement simultané et exécution immédiate<script src="chat-widget.js" defer></script>: Téléchargement parallèle avec exécution après le parsing HTML. La solution généralement préférable.- Éviter les décalages de contenu (CLS) : Réservez l'espace nécessaire aux éléments chargés dynamiquement. Définissez leurs dimensions (

width/height) ou utilisez la propriété CSSaspect-ratiopour préserver la stabilité visuelle.

Gestion optimisée des scripts tiers

Les scripts externes (analytics, pubs, widgets) sont souvent les plus néfastes pour les performances .

💡 Conseil pro : Différez leur chargement jusqu'à la première interaction utilisateur (clic, scroll, survol). Cette technique protège vos Core Web Vitals sans sacrifier les fonctionnalités.

Implémentez cette solution avec un simple gestionnaire d'événements :

Stratégies de rendu : choisir la bonne approche

Le choix de votre stratégie de rendu influence directement les performances SEO de votre application JavaScript . Chaque méthode offre des bénéfices spécifiques selon vos besoins.

| Stratégie | Cas d'usage optimal | Avantages SEO | Limitations |

| SSR (Server-Side Rendering) | E-commerce, contenus fréquemment mis à jour | Indexation immédiate, contenu toujours frais - idéal pour le référencement | Charge serveur plus élevée, développement plus complexe |

| SSG (Static Site Generation) | Sites vitrines, blogs, documentations | Performance maximale grâce au CDN, excellente compatibilité avec Google | Nécessite un rebuild complet pour toute modification |

| Prerendering dynamique | Migration progressive d'applications existantes | Solution équilibrée, implémentation simple | Coûts variables, risque d'incohérence |

Maîtriser l'hydratation pour un SEO optimal

Dans une approche hybride, le serveur envoie d'abord du HTML statique (accélérant ainsi le chargement pour Google et les utilisateurs), puis le JavaScript côté client intervient pour "hydrater" la page et la rendre interactive.

Analogie pratique : Imaginez recevoir une maison pré-construite (HTML statique) à laquelle vous ajoutez ensuite l'électricité et la plomberie ( JavaScript ) pour la rendre pleinement fonctionnelle.

Point crucial : Le HTML généré côté serveur doit parfaitement correspondre au résultat après hydratation. Toute divergence peut provoquer des problèmes de rendu et nuire à votre SEO technique .

Le SXO (Search Experience Optimization) montre que le référencement moderne s'appuie autant sur l'expérience utilisateur que sur les techniques classiques. Pour optimiser le SEO JavaScript , plusieurs bonnes pratiques sont essentielles : réduire l'impact du JavaScript sur le rendu et les performances en minifiant les fichiers, en retardant les scripts non critiques et en allégeant le thread principal. Privilégier le rendu côté serveur ou le prerendering garantit une meilleure indexation du contenu dynamique par Google . L'adoption du lazy-loading et des formats d'image modernes améliore notablement les Core Web Vitals (LCP < 2,5s, CLS minimal). Une structure sémantique rigoureuse et des données structurées enrichissent le contenu, tandis que des outils comme PageSpeed Insights et la Search Console permettent d'évaluer précisément l'impact sur le trafic et les conversions. Découvrez nos conseils pour optimiser JavaScript et booster à la fois SEO et UX .

Gouvernance des scripts avec Google Tag Manager

Finis les scripts ajoutés manuellement dans le code ! Google Tag Manager (GTM) constitue une solution indispensable pour piloter efficacement vos balises marketing et analytiques sans compromettre votre SEO .

- Centralisation optimisée : Migrez tous vos trackers (GA4, Meta Pixel, LinkedIn Insight Tag) vers GTM pour clarifier votre code source et optimiser les temps de chargement.

- Chargement asynchrone : Le conteneur GTM exécute naturellement les scripts de façon asynchrone, protégeant ainsi les Core Web Vitals cruciaux pour votre référencement .

- DataLayer structuré : Implémentez un

dataLayerrobuste pour transmettre les données depuis votre backend vers GTM de manière fiable, sans recourir à des analyses DOM fragiles. - Conformité RGPD : GTM facilite la mise en œuvre du Consent Mode v2, ajustant automatiquement les balises selon les préférences de consentement des visiteurs.

// Exemple d'implémentation dataLayer pour e-commerce

dataLayer.push({

'event': 'purchase',

'ecommerce': {

'transaction_id': '12345',

'value': 99.99,

'currency': 'EUR'

}

});

Garantir l'indexabilité de vos pages JavaScript

Même si vous avez un rendu parfait en JavaScript côté client , certaines erreurs élémentaires peuvent compromettre votre SEO . Ces règles fondamentales sont essentielles pour toute optimisation efficace.

URL et maillage interne crawlables

L'important à retenir : vos liens doivent toujours utiliser la balise HTML standard . Préférez systématiquement la syntaxe <a href="/ma-page"> pour la navigation. Les robots des moteurs de recherche ne lisent que l'attribut href - ils n'exécutent jamais les scripts onClick.

Voici la bonne méthode pour implémenter la navigation dans une application single page :

<a href="/produits/chaussures-running" onclick="navigateSPA('/produits/chaussures-running')">Chaussures Running</a>

Métadonnées stables et fiables

Les balises title, meta description, canonical et les données structurées sont cruciales pour le SEO . Elles doivent impérativement figurer dans le code HTML source envoyé par le serveur. Les générer uniquement via du JavaScript côté client fragilise l'indexation.

Exemple de structure bien optimisée :

<head><title>Chaussures Running Premium | Notre Boutique</title><meta name="description" content="Découvrez notre sélection de chaussures running premium pour tous terrains."><link rel="canonical" href="https://example.com/produits/chaussures-running" /><script type="application/ld+json">{"@context": "https://schema.org","@type": "Product","name": "Chaussures Running Premium"}</script></head>

Audit SEO JavaScript : méthodologie complète

Pour optimiser le référencement naturel de votre application JavaScript, un audit technique régulier s'impose. Voici une méthode éprouvée par des experts en JavaScript et en SEO.

Ce guide pratique vous montre comment évaluer l'impact du JavaScript sur votre SEO :

- Contrôle du crawl et du rendu (vérification des robots.txt, sitemap et tests d'indexation)

- Identification des scripts problématiques

- Évaluation de l'expérience utilisateur réelle

- Mise en œuvre d'optimisations ciblées (décalage des scripts non critiques, chargement asynchrone, lazy-loading et gestion du cache)

Le tout en mesurant précisément l'impact sur les Core Web Vitals grâce aux outils Google Search Console, PageSpeed Insights et Screaming Frog. Nous abordons également la priorisation des corrections et l'importance d'un suivi continu après migration pour maintenir une bonne exploration et indexation par les moteurs de recherche .

Consultez notre guide complet d'audit technique SEO incluant l'optimisation JavaScript

- ✅ Test sans JavaScript : Utilisez une extension navigateur pour désactiver temporairement JavaScript. Vérifiez que votre contenu principal, votre navigation et vos liens restent accessibles. Ce test évalue votre dépendance au rendering côté client.

- ✅ Comparaison Source vs Rendu : Comparez le code source initial (

Ctrl+U) avec le DOM final dans les outils développeurs. Votre contenu clé nécessite-t-il un rendu dynamique pour s'afficher ? - ✅ Crawl avec simulation JavaScript : Dans Screaming Frog, activez le mode rendering (

Configuration > Spider > Rendering > JavaScript). Comparez les résultats avec/sans JavaScript pour détecter les contenus invisibles au googlebot . - ✅ Validation avec outils Google : Croisez les résultats de l'Outil d'inspection Google Search Console et du Test des résultats enrichis - ils utilisent le même système de rendu que le robot Google.

- ✅ Vérification des ressources bloquées : Assurez-vous que votre robots.txt n'interdit pas les fichiers .js/.css essentiels, indispensables au googlebot pour un bon indexage .

Bonnes pratiques avancées par framework JavaScript

Les principaux frameworks JavaScript proposent des solutions spécifiques pour améliorer le référencement naturel (SEO) . Voici comment tirer le meilleur parti de chaque écosystème.

Next.js (React) - SSR optimisé

- getServerSideProps : parfait pour les contenus dynamiques (e-commerce, profils utilisateurs)

- getStaticProps + getStaticPaths : optimise les pages statiques pour une performance SEO maximale

- next/head : gestion dynamique des balises méta

Angular Universal - rendu universel

- Server-side rendering natif via Angular Universal

- Gestion optimisée des balises avec les services

MetaetTitle - Contrôle fin du processus d'hydratation

Vue.js + Nuxt.js - Performance et SEO

- Architecture universelle idéale pour le rendu et le SEO

- Optimisation automatique du fichier robots.txt

- Génération intelligente du sitemap XML